La simulation par Bootstrap¶

Parmi les techniques de ré-échantillonnage les plus utilisées, on trouve le bootstrapping, le jackknif et les tests de permutation.

Ces méthodes permettent d’estimer la précision d’un échantillon statistique (médiane, variance, quantile) en utilisant des sous-ensembles des données disponibles (jackknife) ou en effectuant un tirage aléatoire avec remise, à partir de ce même ensemble de données (bootstrap).

La méthode bootstrap a été introduite dans les années 1970 lorsque les calculs informatiques commençaient à être de plus en plus accessibles. Avec cette méthode, les statisticiens pouvaient alors mesurer la sensibilité des estimations des mesures de dispersions (variance, écart-type) aux particularités de l’échantillon étudié. Cette méthode de simulation crée de nouveaux échantillons à partir de l’échantillon de base.

Bootstrap non paramétrique¶

Supposons que nous ayons les observations Y1,Y2,…,Yn i.i.d tirées d’une fonction de distribution inconnue. On peut alors construire un estimateur:

On voudrait alors analyser les propriétés de ˆθn pour un quelconque ensemble A;

Puisque nous ne connaissons pas F, nous ignorons complètement ses propriétés, nous choisissons alors une approximation empirique de la fonction de distribution des observations par,

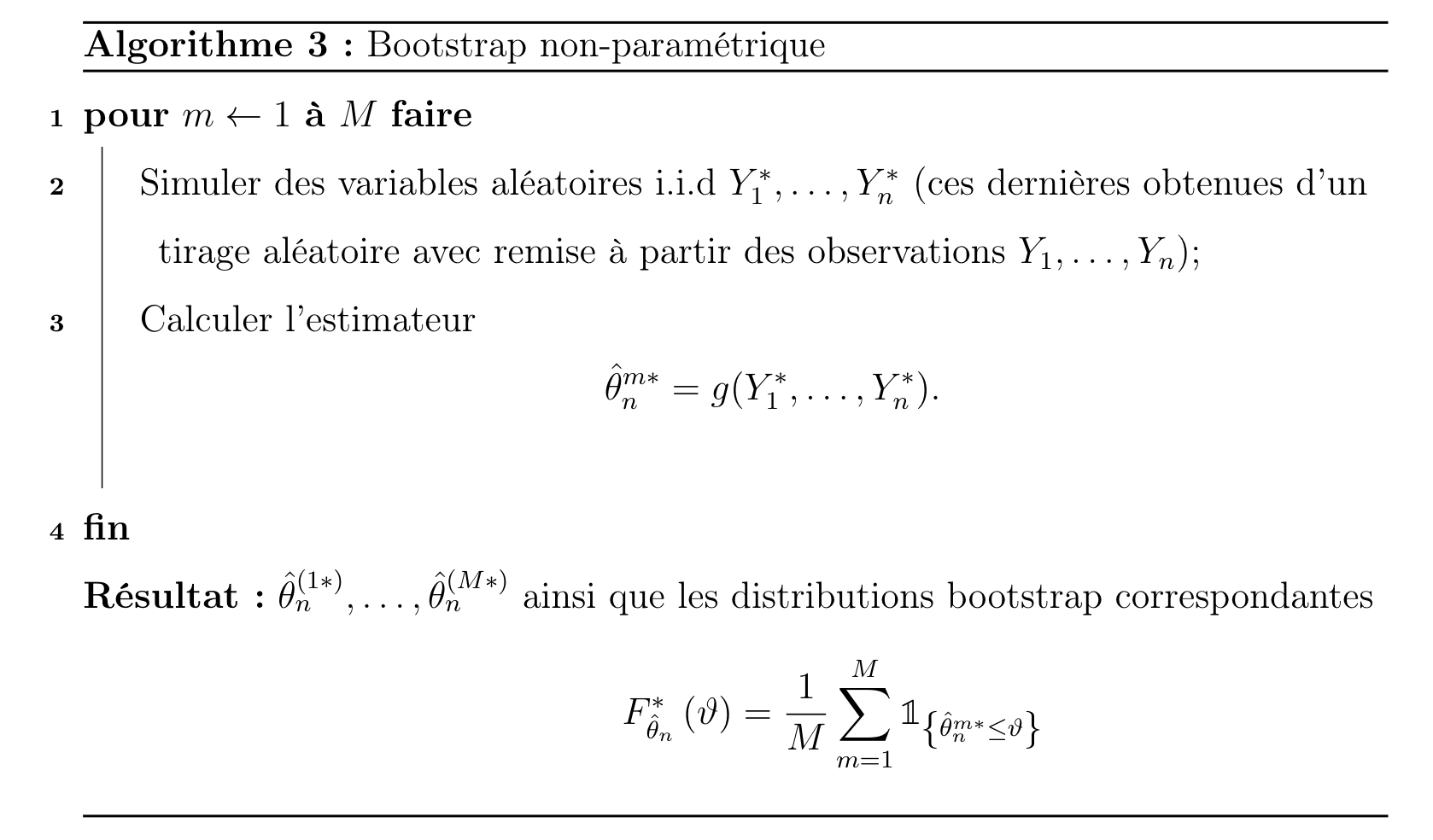

On simule alors directement de la distribution empirique ˆFn au lieu de F. Cette simulation donne lieu à l’algorithme suivant \cite{wuthrich2017data};

On peut alors utiliser la distribution F∗ˆθn comme une estimation de la distribution de ˆθn que nous avons définie à l’équation (10). Nous estimons alors,

Bootstrap paramétrique¶

Avec la méthode bootstrap paramétrique, nous faisons une hypothèse sur la fonction de distribution paramétrique F=Fθ avec le paramètre inconnu θ pour les observations iid, Y1,Y2,…,Yn . On peut construire notre estimateur,

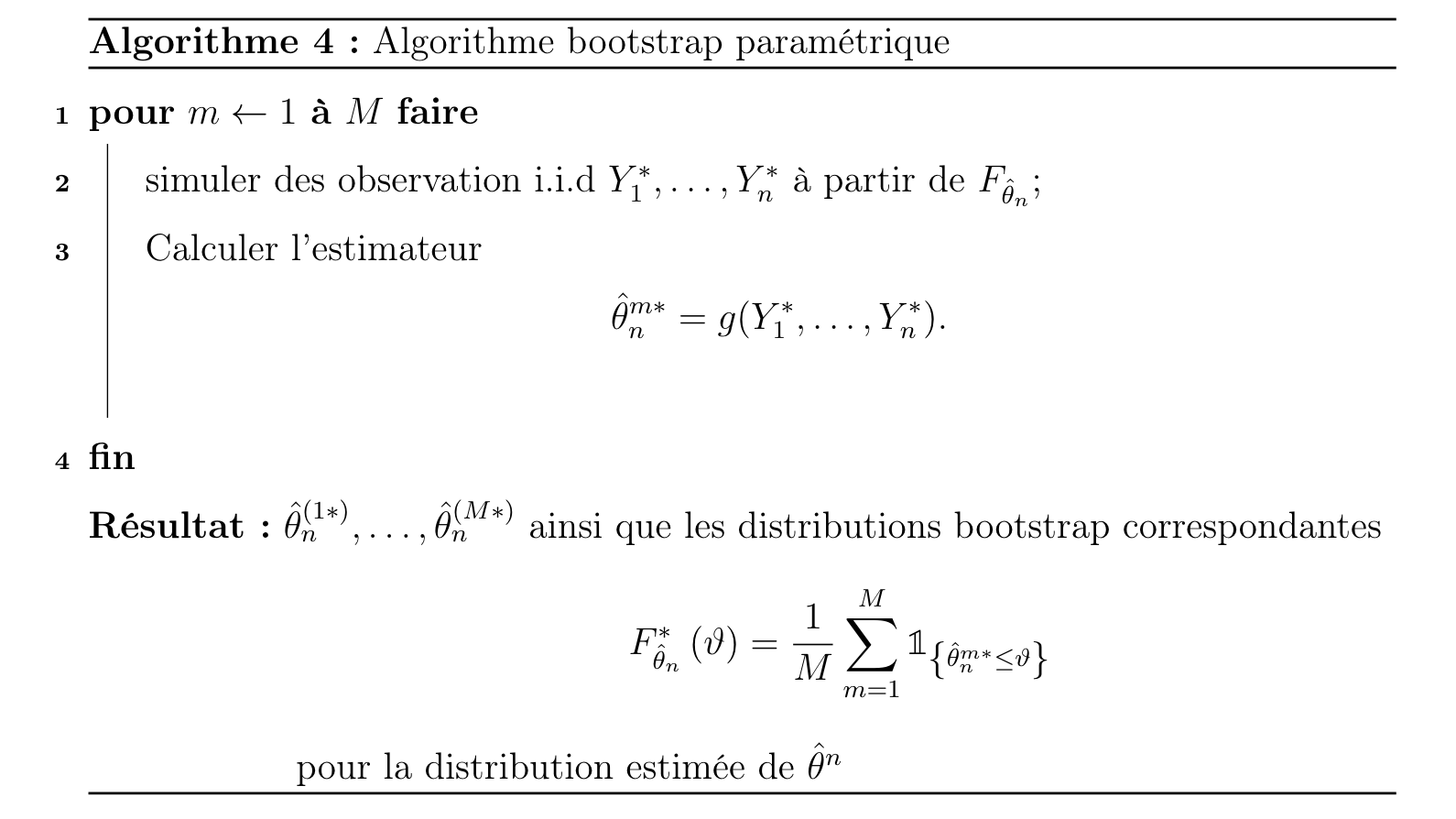

L’algorithme devient alors,

On estime ainsi la distribution de ˆθn de manière analogue à l’équation (11).

À partir des années 1990, l’idée d’appliquer le bootstraping sur les arbres de décision a commencé à faire son apparition. Cette idée permet de tirer plusieurs avantages tels que la réduction de la variance (loi des grands nombre) ainsi que d’obtenir d’autres estimations statistiques.