Boosting¶

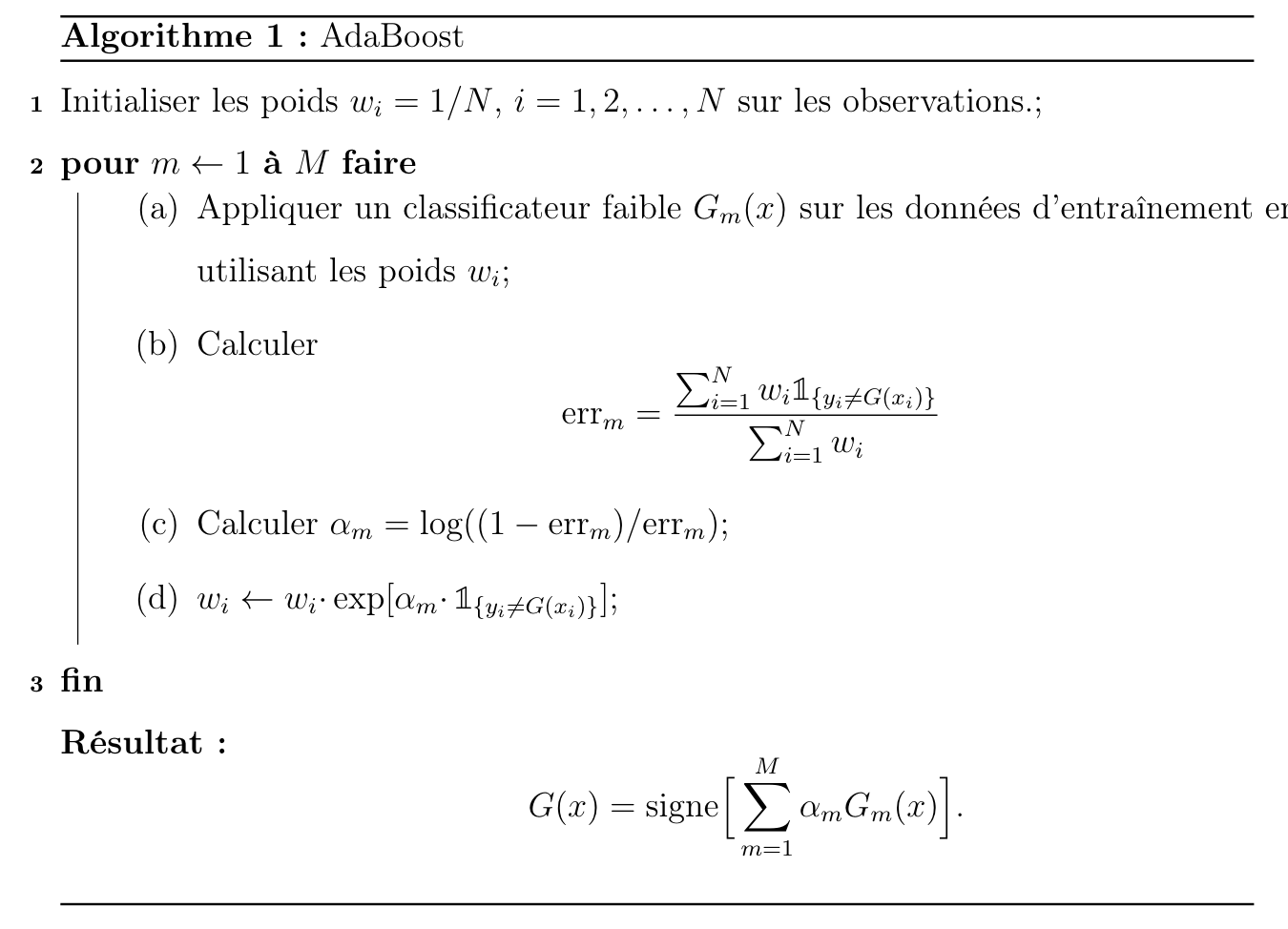

Le boosting est une méthode d’apprentissage d’ensemble qui est fondamentalement différente du bagging et des forêts aléatoires. Au lieu de créer des échantillons indépendants, d’adapter un arbre de décision à chaque échantillon séparément et de faire la moyenne des prédictions de ces arbres pour réduire la variance, le boosting construit une séquence d’arbres interdépendants, chacun étant construit à partir d’arbres précédemment développés et d’une version modifiée des données d’entraînement originales.

Considérons un arbre de régression f1 ajusté à l’ensemble d’apprentissage {(xi,yi)}ni=1. Les résidus donnés par e1i=yi−ˆf1(xi) pour i=1,…,n contiennent la partie des données qui ne peut être expliquée par l’arbre de décision ajusté ˆf1. Cela nous incite à améliorer encore le modèle en faisant croître un deuxième arbre de décision ˆf2 (le “2” signifie le deuxième arbre) ajusté au nouvel ensemble d’apprentissage {(xi,e1i)}ni=1, où la variable de réponse est le résidu du premier arbre. La nouvelle prédiction est la somme de la prédiction du premier arbre et de celle du deuxième arbre :

et les résidus correspondants sont $yi−ˆf(x)=[yi−ˆf1(x)]−ˆf2(x)=e1i−ˆf2(x)=e2i$

qui sont les résidus du deuxième arbre. Inductivement, nous pouvons construire une série d’arbres de décision ajustés aux résidus de l’arbre précédent afin d’essayer d’apprendre des données lentement, l’effet étant que chaque arbre se concentrera sur la prédiction des observations que l’arbre précédent a mal prédites. Cela met en évidence une différence essentielle entre le boosting et les forêts aléatoires (y compris le bagging) :

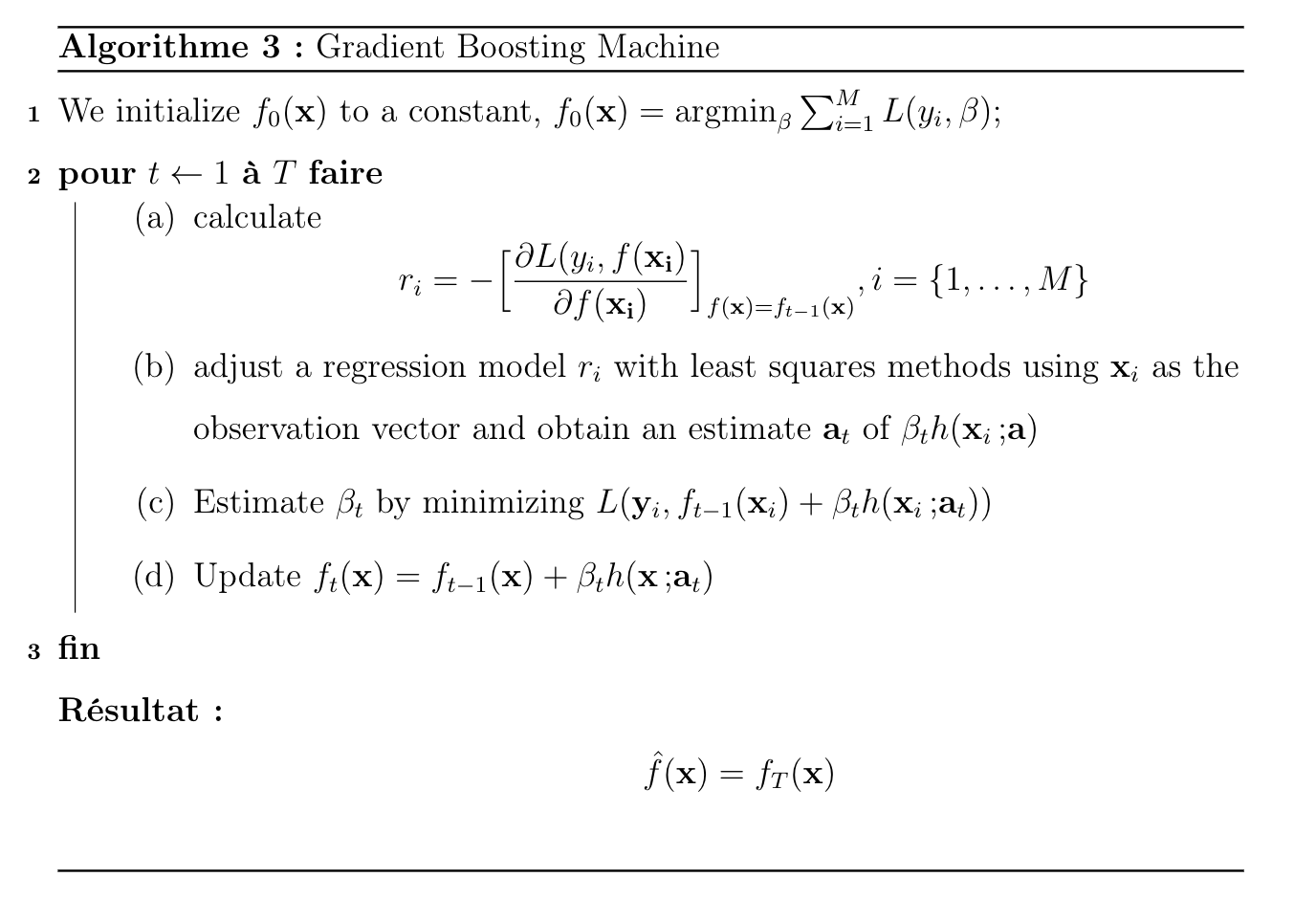

Gradient boosting¶

Le principe de base est le même que pour AdaBoost, construire une séquence de modèles de sorte que chaque étape, chaque modèle ajouté à la combinaison, apparaisse comme un pas vers une meilleure solution. La principale innovation est que ce pas est franchi dans la direction du gradient de la fonction perte l, afin d’améliorer les propriétés de convergence.

Le GBM étend la capacité du Boosting à résoudre les problèmes de régression, il devient ainsi une percée en apprentissage machine. L’algorithme inclut avec succès des éléments statistiques les plus communs, tels que la modélisation additive et le maximum de vraisemblance. Ce faisant, les auteurs ont pu dériver des techniques d’évaluation de la qualité des prédictions du modèle.