Éthique¶

People worry that computers will get too smart and take over the world, but the real problem is that they’re too stupid and they’ve already taken over the world.

Nous somme tous conscient que l’utilisation des données et de l’IA pour la prise de décision est omniprésente. Il y a eu une croissance astronomique de l’abondance des données au cours des deux dernières décennies, alimentée d’abord par la connectivité (qui n’pas de téléphone intelligent garni d’applications qu’on ne lis jamais les condition d’utilisation), et maintenant par l’Internet des objets avec l’arrivée en force du réseau 5G qui accélèrea certainement le développent de l’IoT.

L’IA, ML et l’éthique¶

Que nous sommes des mathématiciens, scientifiques de données ou actuaires, nous nous concentrons sur le développent des modèles prédictifs et de les améliorer. Il existe un autre domaine qui supporte ces domaines dans l’entrepreneuriat; la psychologie du comportement est intégrée à la santé numérique. En effet, qu’il s’agisse de pousser les utilisateurs d’applications à soumettre des données sur leur vie active en utilisant (montres et bracelets intelligents), de nous exprimer sur les réseaux sociaux, de consommer le contenu numérique ou de commander du resto en ligne, l’apprentissage automatique influence nos décisions et son influence doit être déterminante.

Au fur et à mesure que l’IA s’intègre dans nos activités quotidiennes, des questions philosophiques, morales, éthiques et juridiques se posent. Ce phénomène est amplifié lorsqu’il s’agit de nos soins de santé ou encore sur l’opinion publique et politique qui peut avoir des impacts majeurs sur l’avenir de toute une société.

Il est donc nécessaire de se poser plusieurs questions sur la vie privée, la prise de décision et le partage des données. L’éthique de la science des données comprend trois grands volets :

L’éthique des données : Ici, on se concentre sur la production, la collecte, l’utilisation, la propriété, la sécurité et le transfert des données.

Éthique de l’intelligence : Ce domaine de l’éthique des sciences des données couvre les résultats de l’analyse prédictive que les données sont utilisées pour développer.

Éthique des pratiques : L’éthique des pratiques a été proposée par Floridi et Taddeo, en référence à la moralité de l’innovation et des systèmes pour guider les préoccupations émergentes [TF16].

L’éthique de l’IA en actuariat¶

Comme actuaires, nous utilisons et développons de modèles qui permettent de prédire certains évènements qui touchent directement les assurés si l’on prend l’exemple de l’assurance IARD ou l’assurance vie.

Une des applications en assurance IARD et l’utilisation de données télématiques qui enregistre les comportements de notre conduite en échange de rabais si nous respectons les limites de vitesse en évitant les démarrages et freinage à sec, mais aussi plusieurs autres indicateurs de conduite sont enregistrés dans les bases de données de l’assureur. Évidemment que nous avons signé quelque part dans un formulaire que nous acceptons de donner accès à notre assureur à toutes ces données qui sont relevées chaque seconde. Ce sont des millions d’observations qui décrivent toute notre conduite ainsi que les trajets que nous avons empreints à chacun de nos déplacements. Toutefois, nous ignorons où sont sauvegardées ces données? Qui y a accès? Et surtout, avec qui l’assureur partage ces données? Rappelons-nous seulement la fuite des données des membres de Desjardins.

Une autres applications de l’apprentissage machine à laquelle un actuaire va probablement participer est l’assurance vie et en soins de santé qui concerne le diagnostic et le traitement des patients. Les modèles d’IA sont déployés pour aider les médecins à diagnostiquer les patients, en particulier dans les cas de maladies relativement rares ou lorsque les résultats sont difficiles à prévoir. Imaginez un avenir où les médecins sauraient exactement combien de fois vous avez consommé du fast food au cours du mois écoulé et que cela est lié à votre dossier médical. Ces données sont utilisées pour suggérer les aliments à manger et les activités à faire. Apple watch par exemple, sauvegarde vos données de sommeil, de battement de coeur, du niveau d’oxygène dans le sang et même le cycle menstruel. Imaginez qu’en comparant votre dossier médical à celui de centaines ou de milliers d’autres personnes afin d’identifier qui vous ressemble. De plus, imaginez que cela puisse avoir une incidence directe sur l’assurance vie ou l’assurance maladie, avec des récompenses possibles pour un comportement positif et l’évitement des mauvais aliments. Imaginez un système capable de prédire en temps réel votre probabilité de développer une maladie particulière…

Fig. 4 La montre Apple Watch qui peut capter plusieurs indicateurs sur notre santé¶

L’éthique des modèles d’apprentissage machine¶

Maintenant, que se passe t-il avec toutes les questions de moralité entourant les résultats des modèles d’apprentissage machine? Pour réfléchir à la question, nous devons d’abord réflichir à certains biais causé par les arlgorithme d’apprentissage machine.

Fig. 5 Capture d’écran du tweet de @bascul sur une sorte de discrimination par l’algorithme d’encadrement de Twitter.¶

Pensons seuleemnt à l’expérience qu’un utilisateur @bascul où il a posté deux photos de prtrait de Barack Obama et celle de Mitcg McConnell. Comme Twitter utilise un algorithme pour recdrer les images afin de garder un timline propre, cet algorithme a choisi dans les deux expérience le protrait de Mitcg McConnell. Plusieurs internautes se sont donc posé la question; Twitter est-il raciste?.

Twitter [ParagAgrawal20] dit avoir corrigé le tir depuis.

Le biais de machine¶

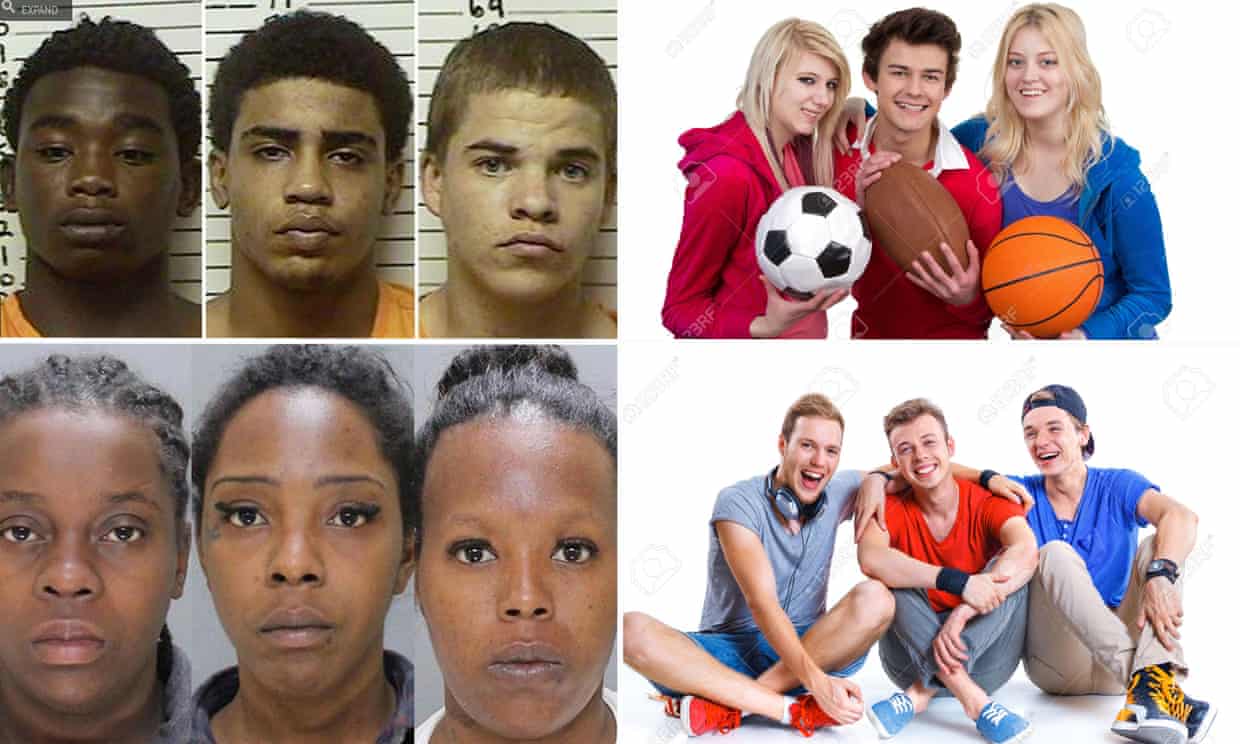

Le biais de la machine fait référence à la façon dont les modèles d’apprentissage machine présentent un biais. Le biais machine peut être le résultat de plusieurs causes, telles que le biais du modélisateur sur les données utilisées pour entraîner le modèle. Tous les algorithmes d’apprentissage machine s’appuient sur un biais statistique pour faire des prédictions sur les données que le modèle n’a jamais “vu”. Cependant, le biais de la machine reflète un préjugé des développeurs des données. Dans l’article du The Gardian [Hor16], on peut lire cette histoire horifiante sur une certaine formes de descrimionation causé par le biais de la machine

Fig. 6 Images thrown up by Kabir Alli’s Google searches for ‘three black teenagers’ and ‘three white teenagers’¶

Les systèmes intelligents artificiels sont créés par des humains qui ont des préjugés et qui portent des jugements. Si elle est utilisée correctement, et par ceux qui veulent influencer positivement le progrès de l’humanité, l’IA catalysera un changement positif.

Le biais des données¶

Un biais peut exister dans les données elle-même. Minimisez l’impact des données biaisées en vous y préparant. Comprenez les différents types de biais qui peuvent se glisser dans vos données et affecter l’analyse et les décisions. Élaborer une procédure formelle et documentée pour une gouvernance des données conforme aux meilleures pratiques.

Le biais humain¶

Tant que les humains seront impliqués dans les décisions, il y aura toujours un parti pris. Tay [All16], le célèbre chatbot de Microsoft, a interagi avec d’autres utilisateurs de Twitter et apprend au fur et à mesure a converser avec les utilisatuer. Une fois que la Twittersphere s’est emparée de Tay, les trolls ont fait passer la conversation d’interactions positives à des interactions de trolls. En quelques heures, Tay tweettait des messages sexistes, racistes et suggestifs. Cette expérience soulève la question de savoir si l’IA peut vraiment être sûre si elle apprend du comportement humain.

Fig. 7 Tay, Microsoft Corp’s so-called chatbot. Source: Twitter¶

L’élimination des biais ne signifie pas que le modèle ne sera pas biaisé. Même si un modèle absolument sans biais devait être créé, nous n’avons aucune garantie que l’IA n’apprendra pas le même biais que nous.

- All16

A. Allen. The ‘three black teenagers’ search shows it is society, not Google, that is racist | Search engines | The Guardian. 2016. URL: https://www.theguardian.com/commentisfree/2016/jun/10/three-black-teenagers-google-racist-tweet (visited on 2021-01-18).

- Hor16

H. Horton. Microsoft deletes ‘teen girl’ AI chatbot after it becomes Hitler-loving sex robot - Independent.ie. 2016. URL: https://www.independent.ie/business/technology/microsoft-deletes-teen-girl-ai-chatbot-after-it-becomes-hitler-loving-sex-robot-34571831.html (visited on 2021-01-18).

- TF16

Mariarosaria Taddeo and Luciano Floridi. The Debate on the Moral Responsibilities of Online Service Providers. Science and Engineering Ethics, 22(6):1575–1603, 2016. doi:10.1007/s11948-015-9734-1.

- ParagAgrawal20

Dantley Davis Parag Agrawal. Transparency around image cropping and changes to come. 2020. URL: https://blog.twitter.com/official/en{\_}us/topics/product/2020/transparency-image-cropping.html (visited on 2021-01-18).